- Privacy: veel commerciële modellen gebruiken jouw data om zichzelf te verbeteren. Wat als die data gevoelig is?

- Hallucinaties: een LLM kan overtuigend klinken, maar toch fout zitten. Zonder bronvermelding weet je nooit of een antwoord klopt.

- Veiligheid en betrouwbaarheid: je wil geen irrelevante of schadelijke antwoorden in een productieomgeving.

Bij DX-Solutions zien we dit vaak terugkomen in klantengesprekken. Bedrijven willen AI inzetten, maar zoeken naar manieren om dat veilig, betrouwbaar en kostenefficiënt te doen.

De bouwstenen voor veilige AI

Open-source LLM’s

Met tools zoals Ollama draai je modellen lokaal of on-premise. Zo hou je de controle over data en voorkom je dat gevoelige informatie het internet opgaat.

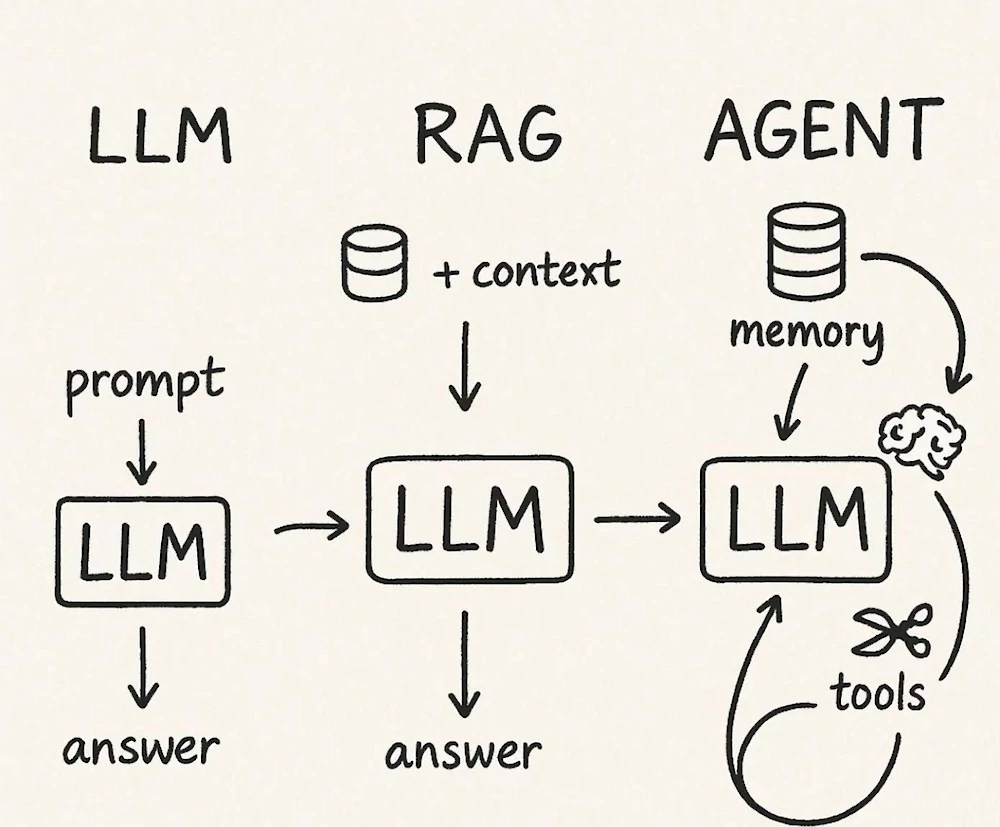

Retrieval Augmented Generation (RAG)

RAG koppelt een LLM aan je eigen databronnen: CRM, documentatie, knowledge base. Het model gebruikt die context om antwoorden te formuleren. Resultaat: betrouwbare en actuele output, onderbouwd met je eigen data.

Guardrails

Guardrails vormen een extra validatielaag:

-

Ze filteren irrelevante of gevaarlijke outputs.

-

Ze bewaken dat een model binnen de gewenste context blijft.

-

Ze zorgen ervoor dat AI bruikbaar wordt in een productieomgeving.

Samen vormen deze drie elementen de basis voor AI die niet alleen slim klinkt, maar ook écht werkt.

Klassiek ML blijft onmisbaar

Niet elk probleem vraagt om een LLM. Klassieke machine learning blijft vaak de betere keuze:

-

Voorspellingen en tabulaire data: churn, lead scoring, fraude → scikit-learn, Random Forests, XGBoost.

-

Tijdreeksen en forecasting: omzet, voorraad, capaciteit → Prophet, LightGBM.

-

Anomaliedetectie: sensordata, transacties → Isolation Forest, One-Class SVM.

In veel trajecten combineren wij beide werelden: klassieke ML voor gestructureerde data, LLM’s voor ongestructureerde data of interactie. Dat levert snellere, robuustere en vaak goedkopere oplossingen op.

Onze ervaring bij DX-Solutions

We zijn geen nieuwkomers in AI. Sinds onze eerste AI-events in 2019 experimenteren we met modellen en toepassingen. Vandaag werken we met modellen van 1.5B tot 70B parameters – en weten we wanneer groot écht beter is en wanneer klein gewoon slimmer is.

Wat onze klanten waarderen:

-

We denken strategisch en business-first, niet alleen technisch.

-

We bouwen hybride oplossingen die kosten en risico’s beperken.

-

We zorgen dat AI in productie komt – niet blijft hangen in experimenten.

Of het nu gaat om een RAG-oplossing voor kennisbanken, een forecasting-model voor sales, of een AI-agent die beslissingen ondersteunt: onze aanpak is altijd pragmatisch, veilig en toekomstgericht.

Conclusie

De hype rond AI draait vaak om de grootste modellen. Maar de echte waarde ontstaat door de juiste architectuur:

-

LLM’s waar ze het verschil maken,

-

klassieke ML waar het sneller en betrouwbaarder is,

-

en guardrails om alles veilig te houden.

Dat is waar wij bij DX-Solutions dagelijks klanten in begeleiden. Niet door AI te verkopen als een wondermiddel, maar door oplossingen te bouwen die betrouwbaar, schaalbaar en businessgedreven zijn.

In veel van onze klantengesprekken komt dezelfde vraag terug: “Hoe zetten we AI in zonder de controle te verliezen?”

Ons antwoord is telkens hetzelfde: door slim te combineren en niet blind te vertrouwen op één model.

Laat je begeleiden door een DX-Solutions expert

Bij DX-Solutions streven we naar keuzevrijheid en onafhankelijkheid op het gebied van technologie. Laat je begeleiden door een onafhankelijke DX-Solutions expert om de beste oplossingen te kiezen en jouw bedrijfsprocessen te optimaliseren.

Contacteer onsGerelateerde artikelen

Van AI-events in 2019 tot experimenten met 1.5B en...

dinsdag 1 juli 2025, Xavier

Bij DX-Solutions zijn we niet gisteren in AI gestapt. Ons eerste AI-event dateert al van 2019. In die tijd stond generatieve AI nog in zijn kinderschoenen, maar wij zagen toen al de enorme potentie voor bedrijven. In 2023 en 2024 organiseerden we opnieuw AI-hackathons, waarin we met klanten en partners verkenden...